在小小的树莓派中运行 70 亿参数的多模态大语言模型

最近,我遇到了一个叫做 Ollama 的有趣项目。它是一个开源项目,可以让你在本地运行各种大型语言模型(LLM)。

在浏览 Reddit 社区时,我遇到了一些讨论如何在Raspberry Pi上运行LLM的帖子。

我很想验证这个“说法”,所以我决定在我的 Raspberry Pi 4 上使用 Ollama 本地运行 LLM。

让我在这篇简短的文章中与大家分享我的实验。

📋本文假设你对 AI、LLM 及其他相关工具和术语有基本了解。

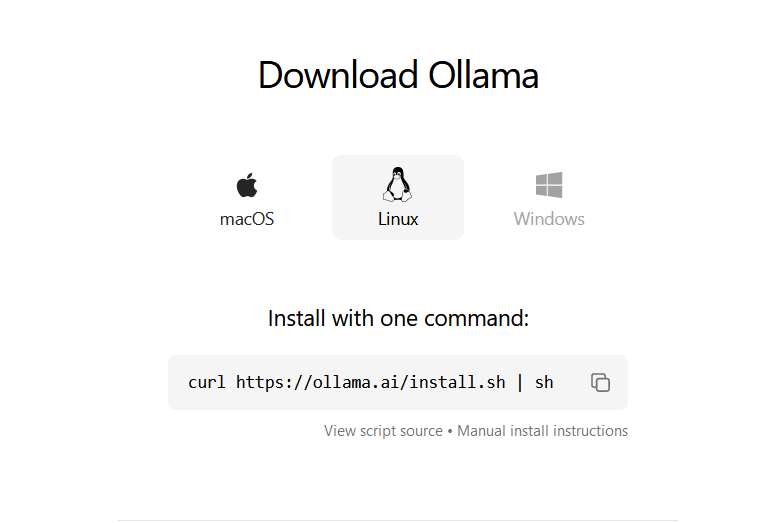

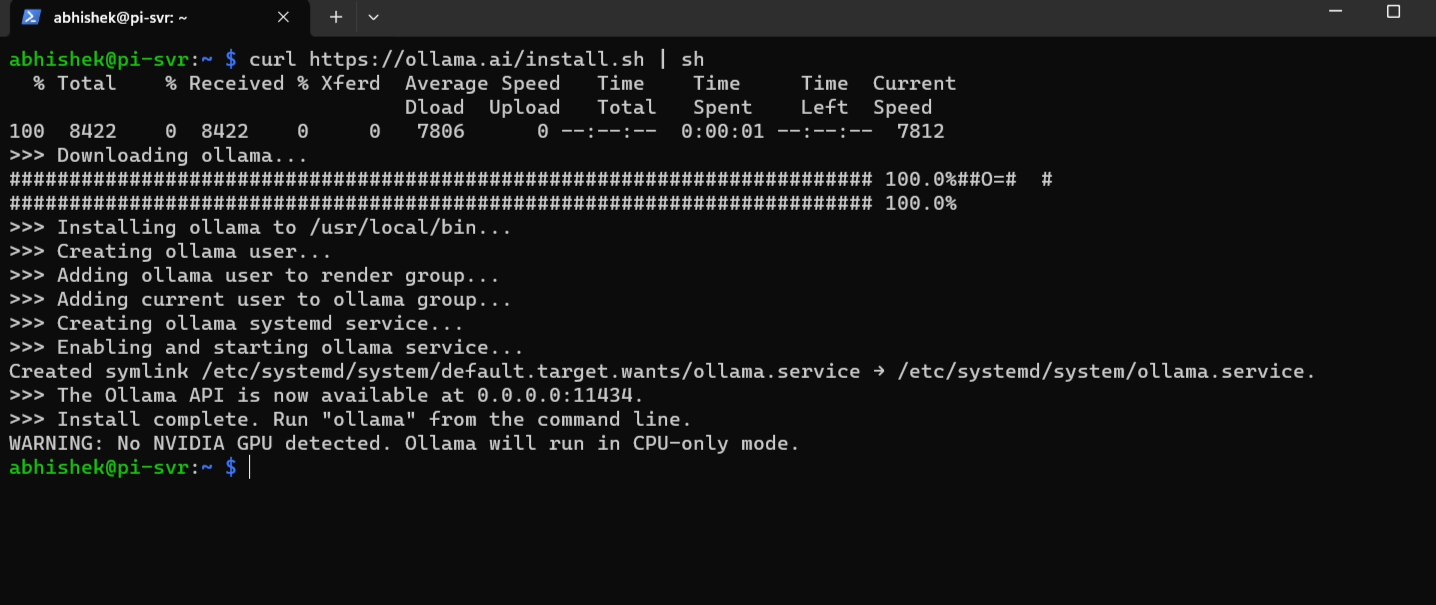

在 Raspberry Pi OS(以及其他 Linux 系统)上安装 Ollama

安装 Ollama 的过程非常简单。要在 Linux 上安装,你只需要获取他们的官方安装脚本并运行它。这是他们网站上描述的官方方法。

你可以手动下载并阅读它的内容。或者,如果你像我一样懒,可以将两者合并为一个命令:

1 | |

探索不同的模型

安装完成后,你就可以在 Pi 上运行 LLM 并开始与 AI 聊天了。

在我的实验中,我使用了 tinyllama、phi 和

llava 这三个 LLM。但你也可以尝试 Ollama

库中其他的语言模型。Ollama

的库里有很多模型。

📋要运行 7B 模型,至少需要 8 GB 的 RAM;要运行 13B 模型,需要 16 GB;要运行 33B 模型,则需要 32 GB。

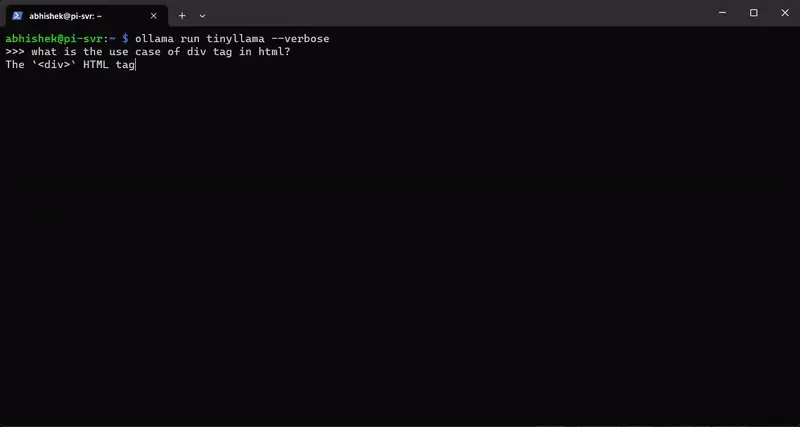

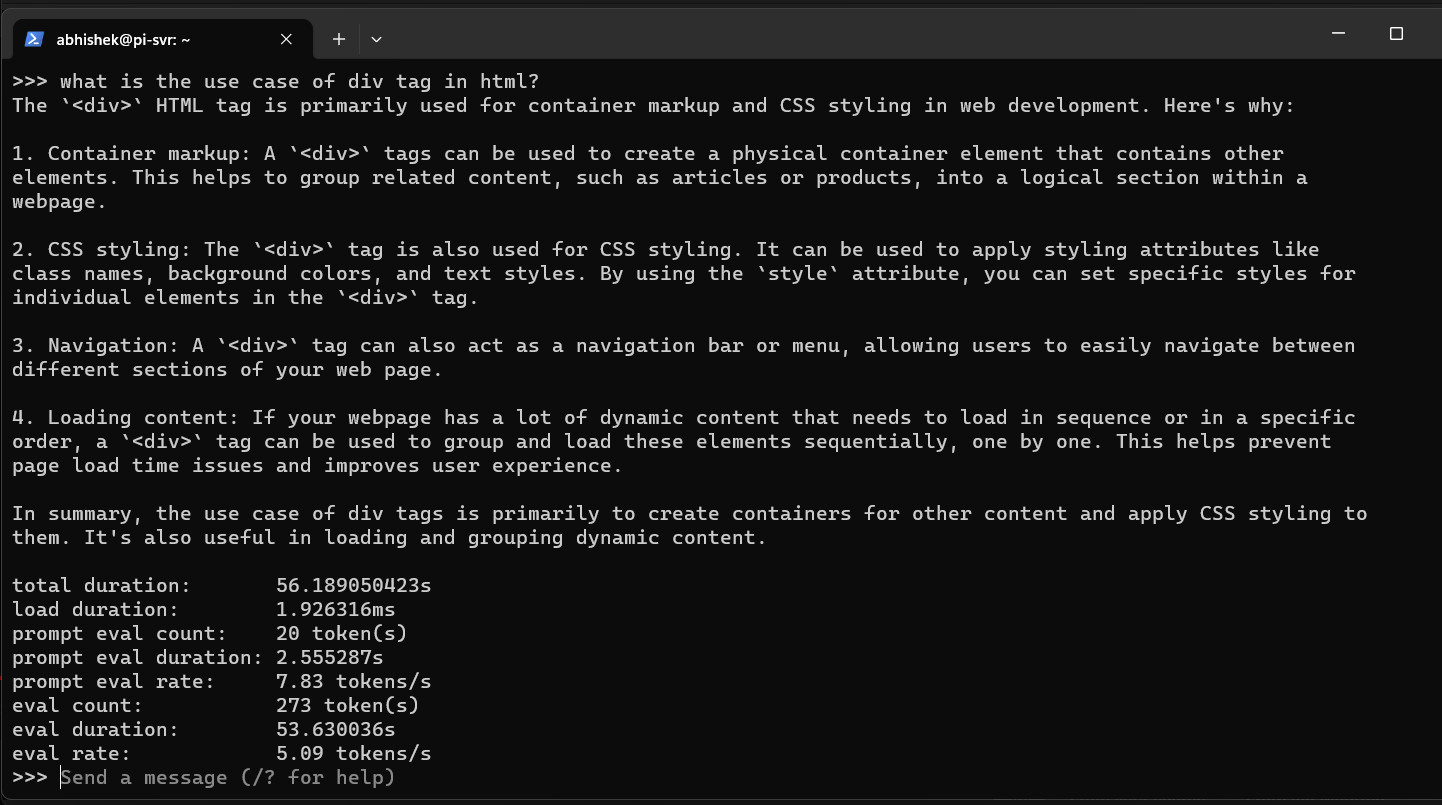

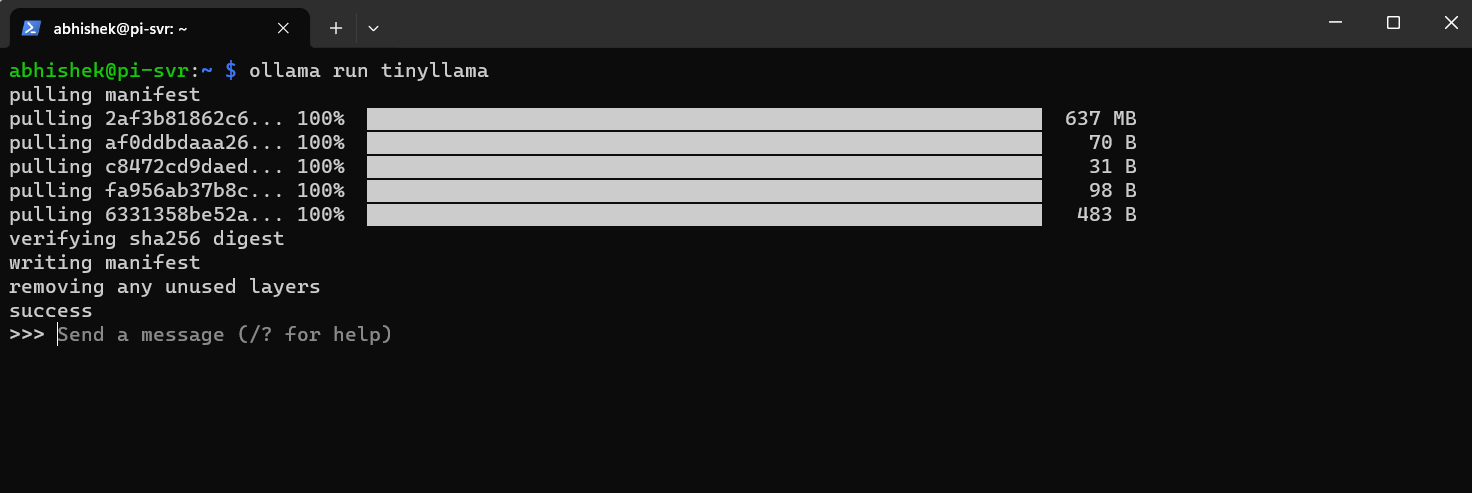

TinyLlama

我们先从 TinyLlama开始,它有 11 亿个参数,是第一个尝试的完美选择。

要下载并运行 TinyLlama,你需要输入以下命令:

1 | |

下载语言模型需要几秒钟,下载完成后,你就可以开始与它聊天了。

我问AI的问题是:“html 中的 div 标签有什么用?”

这是完整的答案和它所花费的时间:

好吧,谁能想到 AI 在 Raspberry Pi 上运行得这么快?

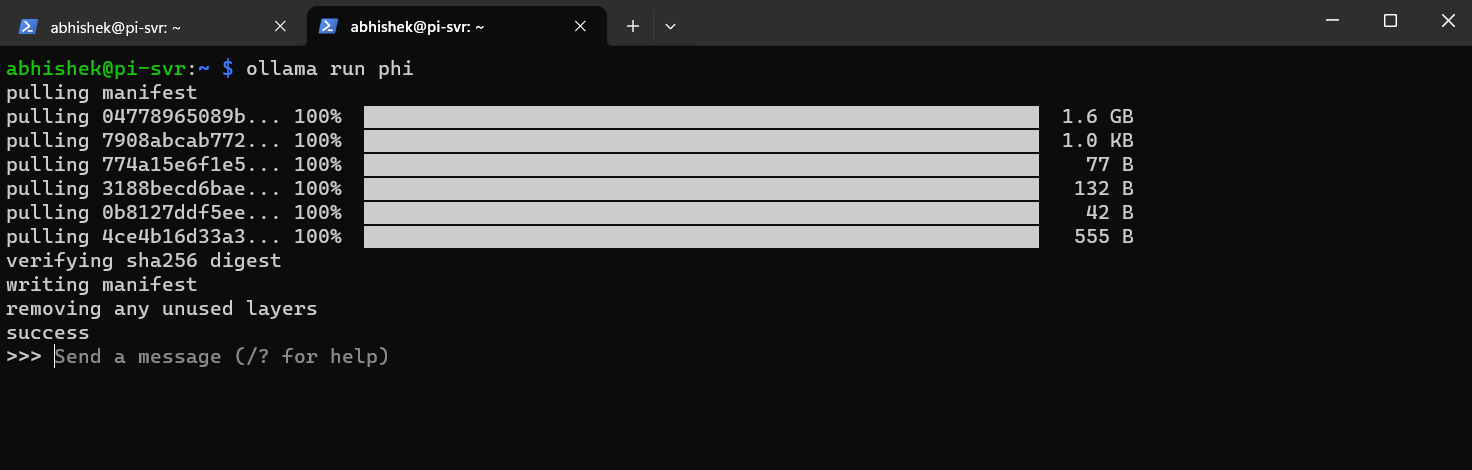

phi

接下来,我们来试试更大的模型,比如 phi,它是一个基于 27 亿参数的语言模型。我认为我们的 Raspberry Pi 也能处理它。

要安装并运行这个模型,输入以下命令:

1 | |

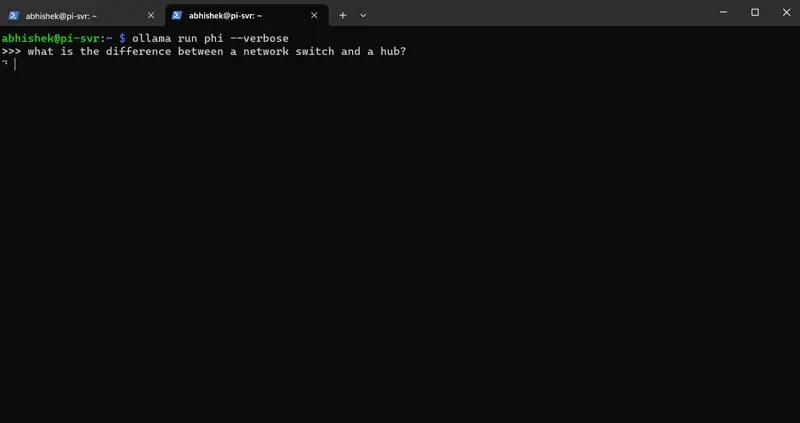

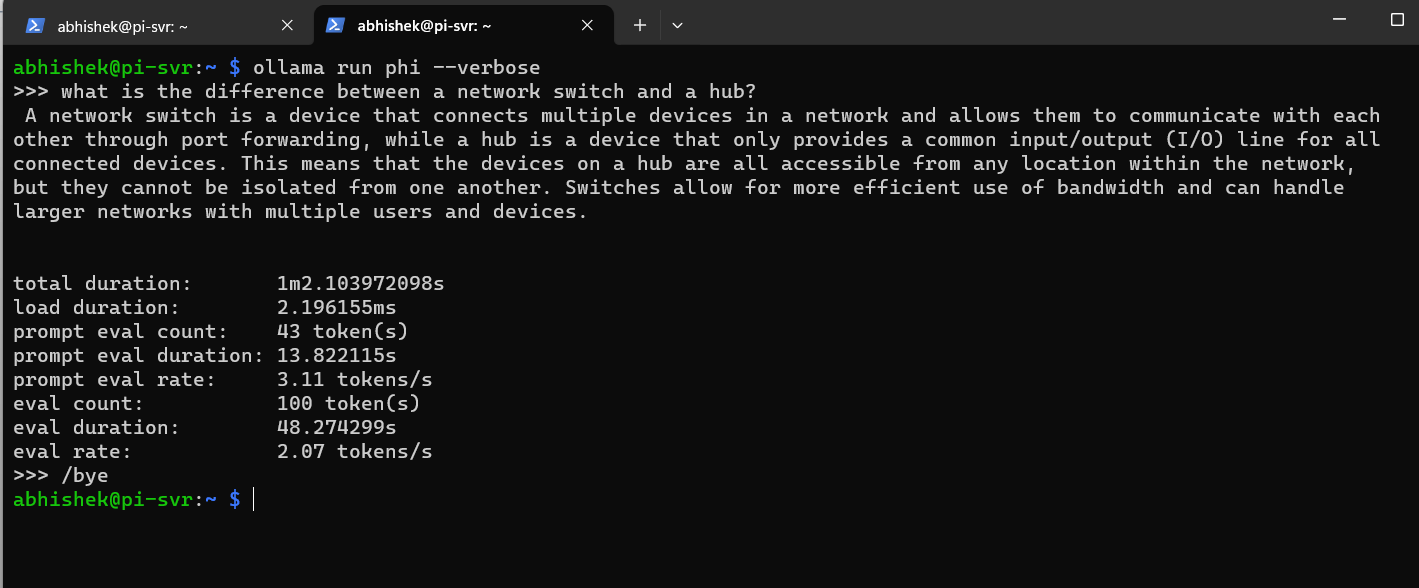

你可以像我一样问它一些问题:“网络交换机和集线器有什么区别?”

这是 phi 给出的完整答案和其他细节:

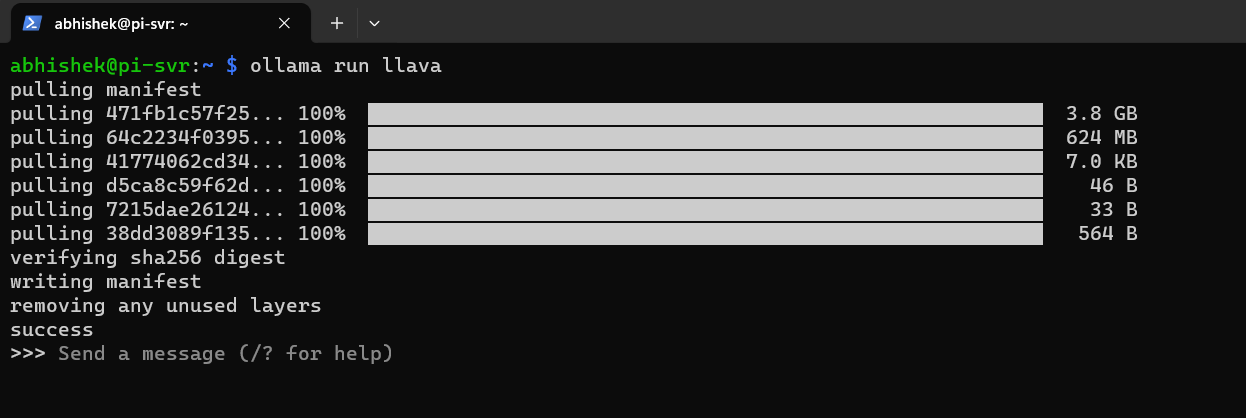

llava

这是我测试的最大的 LLM,它有 70 亿个参数。我要求它描述一张图片,而不是问简单的问题。

我正在使用一个 4 GB 的 Raspberry Pi 4 模型,我觉得它可能无法像之前的语言模型那样运行得很好。

但我们还是来测试一下。要安装 llava,使用以下命令:

1 | |

由于模型较大,大约有 3.9 GB,它需要一些时间来下载。

我将要求这个模型描述存储在 /media/hdd/shared/test.jpg

目录中的一张猫的图片。

我不得不在过程中终止它,因为它回答的时间太长了(超过 30 分钟)。

但你可以看到,回答非常准确,如果你有最新的 8 GB RAM 的 Raspberry Pi 5,你就可以轻松运行 \(70\) 亿参数的语言模型了。

结论

将 Raspberry Pi 5 与 Ollama 结合,建立了一个强大的基础,适合任何希望在本地运行开源 LLM 的人。

无论你是一个开发者,努力推动紧凑计算的边界,还是一个热衷于探索语言处理领域的爱好者,这个设置都提供了无数的机会。

当然,你也可以在普通的 Linux 发行版上使用 Ollama。

欢迎在评论区分享你对 Ollama 的想法和体验。

“觉得不错的话,给点打赏吧 (✿◕‿◕✿)”

微信支付

支付宝支付 (暂不支持)